Szerezz átfogó ismereteket a data engineering területén, ezen belül a Microsoft Azure, Apache Spark (PySpark), adatmodellezés és SQL használatában.

Résztvevőként megtanulhatod, hogyan építs és kezelj hatékony adatfeldolgozási pipeline-okat, hogyan használd az Azure különböző cloud szolgáltatásait az adatok kezelésére, valamint azt is elsajátíthatod, hogyan alkalmazd a legjobb gyakorlatokat az adatmodellezés terén.

Milyen tudásra teszel szert a képzés során?

- Hatékony adatfeldolgozási pipeline-ok építése és kezelése: Megtanulod, hogyan tervezz és valósíts meg hatékony adatfeldolgozási pipeline-okat, amelyek biztosítják az adatok folyamatos és megbízható áramlását és feldolgozását.

- Microsoft Azure cloud szolgáltatások használata: Megismerkedsz az Azure különböző szolgáltatásaival, mint például a Synapse, Databricks, Storage Account és DevOps. Kiemelt hangsúlyt kap az adattárolás, adattranszformációk és ütemezés optimalizálása.

- Apache Spark és PySpark használata: Elsajátítod az Apache Spark és a PySpark alapjait, beleértve a DataFrame-ek kezelését, elosztott rendszerek működését, és a Spark optimalizálási technikáit (shuffling, bucketing, partitioning).

- Data modeling legjobb gyakorlatai: Bemutatjuk a data modeling alapjait, elmélyedsz különböző adatarchitektúrákban (Data Warehouse, Data Lake, Data Mart), valamint az OLTP és OLAP rendszerek közötti különbségeket is megismered. Külön figyelmet kapnak a starschema és snowflake modellek, valamint a Kimball, Inmon és OBT trendek.

- SQL haladó technikák: haladóbb lekérdezési technikákat is megtanulsz majd, melyek segítenek az adatok hatékony lekérdezésében és kezelésében.

- Gyakorlati tapasztalat projektmunkán keresztül: Résztvevőként egy projekt keretében valós adatfeldolgozási feladatokat kell majd megoldanod, így biztosítva a gyakorlati tapasztalat megszerzését és a tanultak mély megértését. Ez a projektmunka természetesen referenciaként is szolgálhat majd a portfóliódban.

Miért érdemes belevágnod?

Az adatmennyiség exponenciális növekedése és az adatalapú döntéshozatal egyre nagyobb hangsúlyt kap az üzleti világban. A vállalatok számára létfontosságú, hogy hatékonyan tudják kezelni, feldolgozni és elemezni adataikat. Ezek megfelelő tárolása, transzformációja és integrációja azonban komoly kihívást jelent nagy mennyiségű adat esetén.

A képzés során megismert modern eszközök és technológiák megoldást nyújtanak ezekre a kihívásokra, lehetővé téve az adatok gyors és hatékony kezelését és az automatizált adatfeldolgozási folyamatok kialakítását.

Ráadásul a tanultakat egy valós életből vett projekten keresztül fogod begyakorolni a data engineer képzés során, melynek végén, ha sikeres vizsgát teszel, Linkedin profilodba is beágyazható, névre szóló tanúsítványt szerzel.

Kinek ajánlott?

1) Azoknak, akik korábban már foglalkoztak adatokkal például Data Analyst, Business Analyst pozícióban és most elmélyednének az adatok világának “backend” oldalában, tehát abban, hogyan lehet előállítani, összegyűjteni és rendszerezni az adatokat, hogy azokat később például adatelemzők felhasználhassák.

2) Azoknak is ajánljuk akár, akik már Data Engineer / ETL fejlesztő pozícióban vagy hasonló munkakörben dolgoznak, de Azure és PySpark technológiákkal még nem dolgoztak.

3) Azoknak, akik szeretnének Data Engineer-ként elhelyezkedni, de még korábban nem foglalkoztak mélyebben adatok kezelésével, nekik a Data Engineer Alapképzésünket ajánljuk, ahol elsajátíthatják az SQL lekérdezések és a Python programozási nyelv alapjait, mely szükséges előfeltétele ennek a képzésnek.

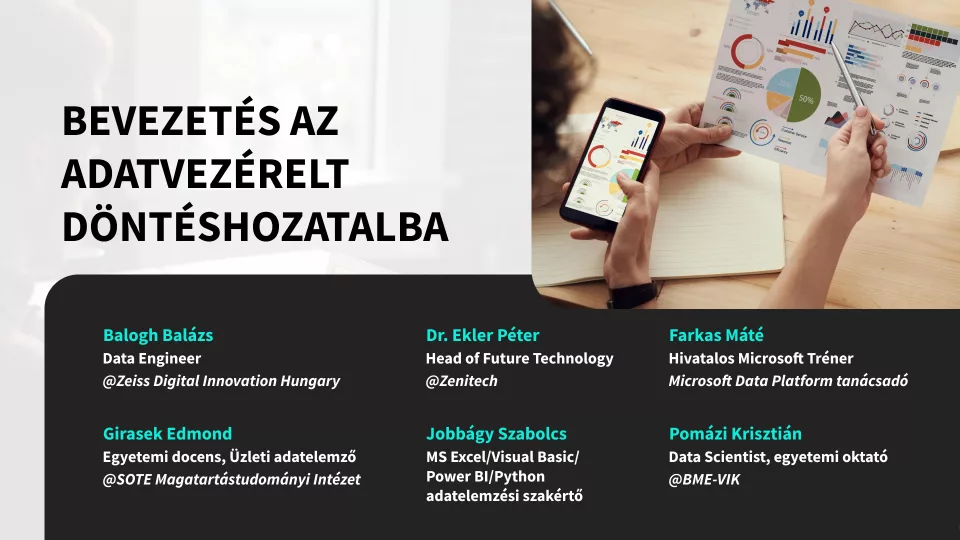

Ki lesz mindebben oktatód és mentorod?

Balogh Balázs - Data Engineer @Zeiss Digital Innovation Hungary

Adatvezérelt megoldások fejlesztésével foglalkozik Data Engineer-ként, jelenleg egy nemzetközi csapat részeként dolgozik a vállalat adatminőségi csapatában. Python, PySpark, SQL és az Azure technológiák segítségével épít adatmegoldásokat – ETL folyamatokat kezel, fejleszt és biztosítja a különböző rendszerek közötti zökkenőmentes integrációt. Emellett PowerBI dashboardokat frissít, hogy a döntéshozók valós idejű betekintést nyerhessenek az adatokba. A szakmai munkája mellett aktív szerepet vállal a közösségépítésben is: a Budapest.py meetup csoport szervezője.

"Hiszek az élethosszig tartó tanulásban, és célom, hogy ne csak az adatokat, hanem a tudást is hatékonyan közvetítsem mások felé."

Mik a képzés előkövetelményei?

SQL adatbázis lekérdezések és Python programozási nyelv ismerete, melyeket ha nem ismersz itt sajátíthatsz el:

Személyes mentorálás és konzultáció

A képzés teljes időtartama alatt lehetőséged van arra, hogy bármikor kérdéseket tegyél fel oktatódnak írásban, valamint a heti élő konzultációs alkalmakon élőszóban is kérdezheted.

Ez a közvetlen kommunikáció biztosítja, hogy a valós iparági tapasztalattal rendelkező oktatóink, akik már számtalan kihívással és feladattal találkoztak a deep learning területén, megoszthassák veled azokat a gyakorlati megoldásokat és tudást, amelyek valós lépéselőnyt biztosítanak számodra.

Ez a folytonos támogatás és interakció teszi lehetővé, hogy a tanultakat azonnal a gyakorlatban is alkalmazhasd, és így a kurzus során minden felmerülő kérdésedre szakmai szempontból megalapozott választ kapj.

Hogyan fogsz tanulni?

- Gyakorlatorientált oktatás: minden héten izgalmas gyakorló feladatokat kapsz majd, amelyek keretében már menetközben is konkrét projekteket fogsz megvalósítani.

- Interaktív digitális tananyag: a gyakorlati feladatok elvégzéséhez és a tanfolyam sikeres teljesítéséhez szükséges tudást digitális tananyagok és vezetett kódolások formájában adjuk át

- Rugalmas időbeosztás: a tanfolyamot munka mellett is végezheted, hiszen a tananyag elsajátítása heti 8-12 óra elfoglaltságot igényel összesen, melyet saját időbeosztás szerint dolgozhatsz fel.

- Oktatói mentoring: a képzés ideje alatt az oktató folyamatosan a rendelkezésedre áll, bármikor kérdezhetsz tőle, ha elakadtál, és rendszeresen visszajelzést ad a feladataidra, fejlődésedet végigkíséri.

- Konzultációk: valamennyi tanegység végén egy-egy élő konzultációs alkalmat is szervezünk este 18:00 órától, amikor élőben is felteheted kérdéseidet, közösen kiértékelhetitek és átbeszélhetitek a gyakorlás során elkészített projekteket, és tanulhattok egymás elakadásaiból is.

- Visszanézhető LIVE alkalmak: az online élő konzultációk átlagosan kb. 1 órásak. Akkor sincs semmi baj, ha egy élő konzultációs alkalmon nem tudsz részt venni, hiszen a kérdéseid előre is elküldheted írásban, a válaszokat és az egész LIVE-ot pedig visszanézheted másnap 16:00 órától.

- Limitált férőhely: a fent említett interakciók miatt képzéseinket korlátozott létszámmal indítjuk csak el, hogy biztosan jusson mindenkire ideje az oktatóknak.

Mikor indul a képzés és mennyibe kerül?

Képzés indulásának tervezett időpontja: 2026. szeptember 09.

Részvételi díj: 325.000 Ft

Aktuális képzés csomagjainkat itt tudod megnézni: KÉPZÉS CSOMAGOK

Mit érdemes tudnod a fizetéssel kapcsolatban?

- Pénzvisszafizetési garancia: Biztosak vagyunk a képzés tartalmát és minőségét illetően, ezért a képzés indulásától 8 napig 100%-os pénzvisszafizetési garanciát vállalunk.

- Kamatmentes részletfizetés: Nem szeretnénk, ha fizetési nehézségek akadályoznák a szakmai fejlődésedet, ezért a részvételi díjat akár több részletben is fizetheted, teljesen kamatmentesen.

- Céges számla igénylése: erre is van lehetőség ha a beiratkozom gombra kattintás után elérhető jelentkezési űrlapon kipipálod az “Áfás számla igénylés”-t.

- Utalásos fizetés: Amennyiben az online kártyás fizetés helyett utalással szeretnél fizetni, csak válaszd ezt az opciót a tanfolyam jelentkezési űrlapjánál a "beiratkozom" gombra kattintás után.

Ha érdekel a képzés két lehetőséged is van

-

Jelentkezel a képzésre Ha eldöntötted, hogy jelentkezel a képzésre és szeretnéd biztosítani helyedet, nincs más teendőd, mint a 'Beiratkozom' gombra kattintva kitölteni a jelentkezési formot és kifizetni a képzés díját.

- Kérdezel még a képzésről Ha szívesen jelentkeznél, de úgy érzed még van néhány kérdés, amire nem találtad meg a választ, kattints az ‘Érdekel, de kérdeznék’ gombra, add meg elérhetőségedet és 48 órán belül felvesszük veled a kapcsolatot vagy írhatsz is nekünk közvetlenül az info@cubixedu.com e-mail címre!

Nem megfelelő ez az időpont?

Nézz körbe az alábbi oldalon, hogy mikor indul legközelebb ez vagy a témában releváns képzés: DATA SCIENCE KÉPZÉSEK

Vagy írj nekünk az info@cubixedu.com címre és értesítünk, amikor megvan már a következő csoportok időpontja!

Nézz szét ingyenes tartalmaink között

Nézd vissza releváns webináriumainkat, ahol meghívott szakértőinktől vagy akár a képzés oktatójától tudhatsz meg még többet számos témáról: WEBINÁROK

Ha pedig inkább olvasnál a témában, akkor nézz körbe releváns blogbejegyzéseink között: TECH BLOG

================

A változás jogát fenntartjuk.