Online akadémia

IT szakembereknek

Gyakorlatorientált informatikai- és data science képzések,

tapasztalt iparági szakemberek mentorálásával,

piacvezető technológiai vállalatok és felsőoktatási intézmények

szakmai minőségbiztosításával.

Java Spring Boot backend fejlesztő képzés [INDULÁS: 2021.03.17.]

Tényleg elég "intenzív" volt, de a videók és magyarázatok alapján teljesíthető. Köszönöm az élményt!

Data Analyst alapok: SQL lekérdezésektől a Power BI adatvizualizálásig [INDULÁS: 2023.06.08.]

Részletes és nagyon jól felépített tananyag.

Javascript alapozó képzés (css, html, javascript) [INDULÁS: 2022.01.18.]

Szenzációsan jó. Tökéletes a tagolás, helyes a fogalomkezelés, jó a felépítés.

Adatbázisok fejlesztése Microsoft SQL Server környezetben [INDULÁS: 2023.05.02.]

Kiváló az oktató. A tananyagon kívül is nagyon sok hasznos dolgot tanít nekünk.

Java backend alapozó képzés [INDULÁS: 2022.02.10.]

Kedves, segítőkész oktató. Haladó témákat is karcolgattunk.

Java Spring Boot alapú backend fejlesztés [INDULÁS: 2023.09.26.]

Mindenképpen jó alapokat ad, ajánlott!

Data Challenge – Tervezd meg a következő Hollywood-i kasszasikert adatok alapján!

Változatos izgalmas kicsit sűrű de szuper, élvezem nagyon!

Javascript alapozó képzés (css, html, javascript) [INDULÁS: 2021.06.15.]

Nagyon jó, informatív

- MS Excel alapok: Shortcutok, Képletek, Kimutatások

- MS Excel Képletek Haladó

- Alkalmazott statiszitka a Data Science-ben

- Business Intelligence rendszerek fejlesztése

- Data Analyst alapok: SQL lekérdezésektől a Power BI adatvizualizálásig

- Adatalapú folyamatoptimalizáció a Process Mining módszertan és MS Power Automate használatával

- Python alapú data analyst képzés adatelemzési és gépi tanulási könyvtárak használatával

- Adatvizualizáció UI/UX szemlélettel

Data Analyst

Ajánlatot kérek ›- Python programozás alapok

- DevOps a gyakorlatban: Cloud-native szoftverfejlesztés Kubernetes és Docker segítségével

- Python alapú data analyst képzés adatelemzési és gépi tanulási könyvtárak használatával

- Machine Learning projektek üzleti- és technológiai kihívásai a gyakorlatban

- Deep Learning a gyakorlatban

- AIOps & MLOps - AI üzemeltetés és biztonság

- ML Engineering: Machine Learning modellek fejlesztése

Machine Learning Engineer

Ajánlatot kérek ›- Bevezetés a Python programozásba

- Python programozás alapok

- Python fejlesztés középhaladó szinten

- Adatbázis lekérdezések SQL segítségével

- Adatbázisok fejlesztése Microsoft SQL Server környezetben

- DevOps a gyakorlatban: Cloud-native szoftverfejlesztés Kubernetes és Docker segítségével

- Python alapú webfejlesztés Django keretrendszerrel

Python Szoftverfejlesztő

Ajánlatot kérek ›- Webfejlesztés alapjai: HTML, CSS, JavaScript, Web API

- JavaScript és TypeScript alapok webfejlesztéshez

- Szoftverfejlesztési eszközök és módszerek

- Node.js alapú backend fejlesztés

- Angular/React alapképzés

- Adatbázis lekérdezések SQL segítségével

- Adatbázisok fejlesztése Microsoft SQL Server környezetben

- Alkalmazásközpontú NoSQL adatbáziskezelés Redis és MongoDB használatával

- Full-stack fejlesztő képzés AWS használatával

Full-Stack Fejlesztő

Ajánlatot kérek ›Tanulás útvonalak az elkötelezetteknek

Ha már most tudod mik a távolabbi céljaid, válassz 25+ előre összeállított tematikus útvonalunk közül vagy állíts össze egyedi képzéscsomagot saját igényeid alapján, és akár több 100.000 Ft kedvezményre is szert tehetsz.

Munkatársaidnak keresel képzést?

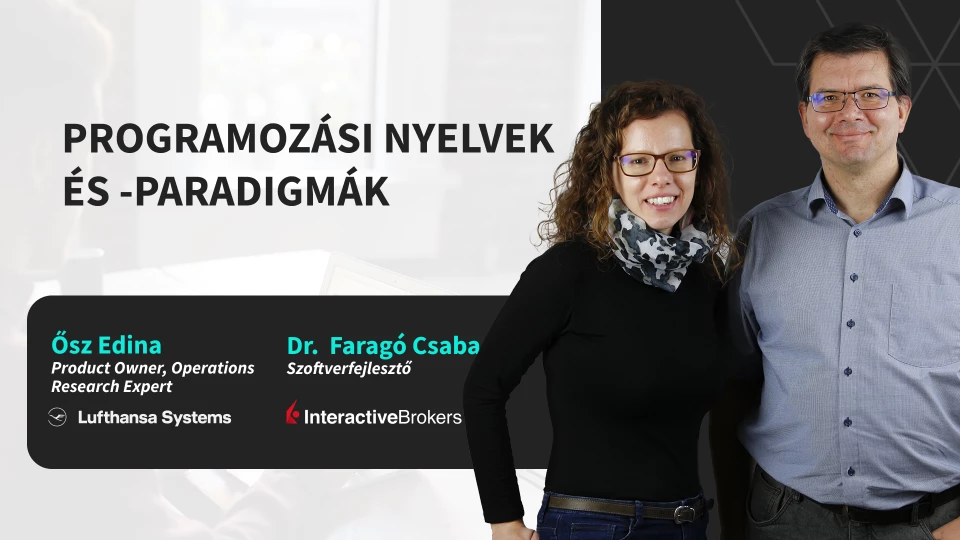

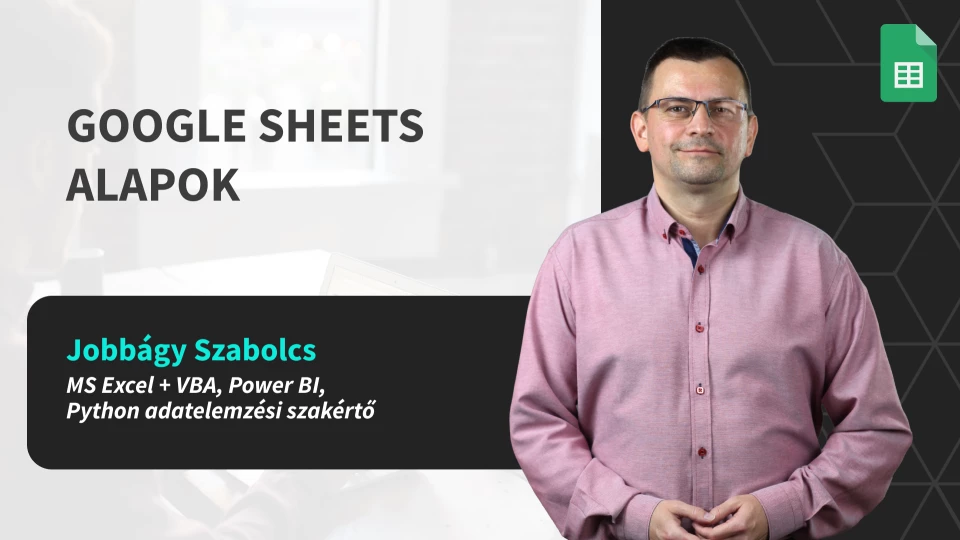

Akadémiai tudást ötvözzük

az iparági tapasztalattal

Képzéseink oktatói és mentorai az IT iparágban piacvezető cégeknél dolgozó

és/vagy felsőoktatásban is tanító, sok éves gyakorlati tapasztalattal rendelkező szakemberek.

10+ éves online oktatásmódszertani

tapasztalatunkat építjük bele képzéseinkbe

Learn-by-doing módszertan

Learn-by-doing módszertan

Interaktív digitalizált tananyagok

Interaktív digitalizált tananyagok

Valós iparági projektek

Valós iparági projektek

Tesztek és tudáspróbák

Tesztek és tudáspróbák

Munkaidőhöz igazított ütemezés

Munkaidőhöz igazított ütemezés

Folyamatos oktatói mentoráció

Folyamatos oktatói mentoráció

Bárhol, bármikor elérhető tanulási felület

Képzéseink technikai hátterét a több mint

500.000 felhasználó által használt, bármilyen

mobileszközről elérhető Webuni online

oktatási platform biztosítja.

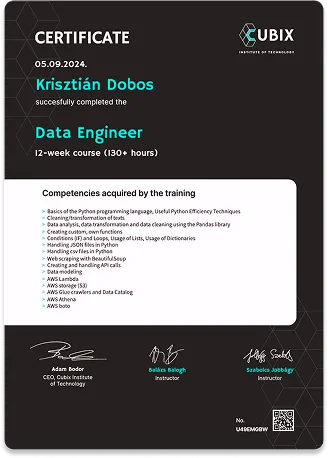

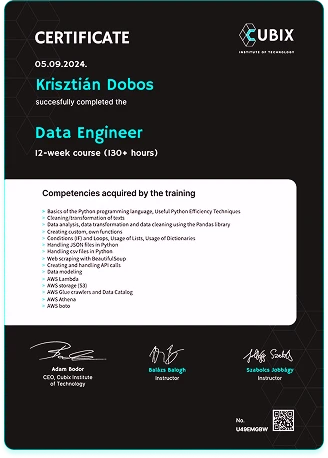

hivatalos tanúsítványok

Képzéseink szakmai minőségbiztosítását és tanúsítványaink érvényesítését az iparági vezető technológiai vállalatok és a közép-kelet-európai régió egyik legjobb műszaki egyeteme, a Budapesti Műszaki és Gazdaságtudományi Egyetem végzi, amely több mint 70 éve foglalkozik villamosmérnöki és informatikai oktatással.

Legyél Te is tagja 6.000+ fős szakmai Alumni közösségünknek!

Blog | 85+ bejegyzés

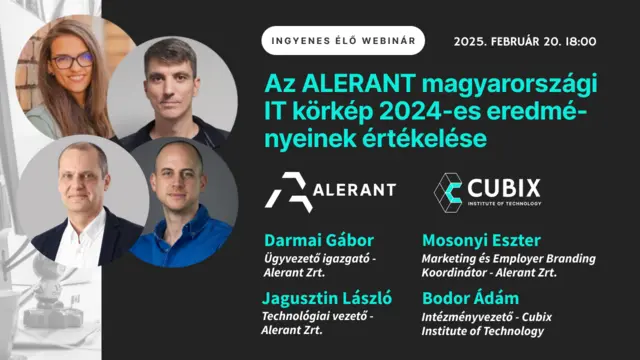

Ahol már találkozhattál velünk az elmúlt években

Offline rendezvények, kiállítások, szponzori- és partner eggyüttműködések, szakmai versenyek, jótékonysági események, sajtómegjelenések